服務近2000家企業(yè),依托一系列實踐中打磨過的技術(shù)和產(chǎn)品,根據(jù)企業(yè)的具體業(yè)務問題和需求,針對性的提供各行業(yè)大數(shù)據(jù)解決方案。

spark機器學習基礎(chǔ)統(tǒng)計學知識

來源:未知 時間:2018-08-14 瀏覽次數(shù):159次

一、矩陣與向量

1.矩陣:按長方陣列排列的實數(shù)或復數(shù)的集合,在程序中以二位數(shù)組存儲,矩陣的運算包括(加,減,乘(數(shù)乘,叉乘),轉(zhuǎn)置,共軛)

scala中創(chuàng)建矩陣(使用breeze包,mllib中的包創(chuàng)建的矩陣無法做計算)

val jz1 = breeze.linalg.DenseMatrix(Array(1,2,3),Array(4,5,6))

2.向量:既有大小又有方向的量稱為向量,矩陣中每一個列可以看做是一個列向量,每一行可以看做是一個行向量,向量的模長看做是向量的大小

向量的N范數(shù)為向量內(nèi)每個元素的N次方和開N次方,P等于2時范數(shù)為向量的摸長

scala中創(chuàng)建向量(使用breeze包,mllib中的包創(chuàng)建的向量無法做計算)

var xl1 = breeze.linalg.DenseVector(1,2,3,4) 加法xl1+xl1

二、統(tǒng)計學基礎(chǔ)

1.平均數(shù)(數(shù)學期望是抽樣的平均數(shù))

2.方差衡量一組數(shù)據(jù)的離散率

3.眾數(shù):是一組數(shù)據(jù)中出現(xiàn)次數(shù)最多的數(shù)數(shù)值,可以是0個或多個

1,2,3,4無眾數(shù)

2, 2, 3,4, 5,眾數(shù)為2

3,4,5,3,5眾數(shù)為3和5

4.中位數(shù):為一組數(shù)據(jù)按大小排序后最中間的那個數(shù)(這組數(shù)據(jù)為偶數(shù)時取中間兩個值得平均值)

5.scala中使用stat.Statistics.colStats()

6.皮爾遜相關(guān)系數(shù):體現(xiàn)兩個變量X,Y線性相關(guān)性的系數(shù),

stat.Statistics.corr(x,y) //x,y為集合或行向量

7.假設檢驗(皮爾森卡方檢驗),先提出假設,然后統(tǒng)計驗證這種假設是否能被拒絕

stat.Statistics.chiSqTest(matrix) //參數(shù)為矩陣數(shù)據(jù)

eg :

男 女

右撇子 127 147

左撇子 19 10

假設性別與左右撇子兩個事件相互獨立,matrix = |127 147 |

|19 10 |

三、基礎(chǔ)算法

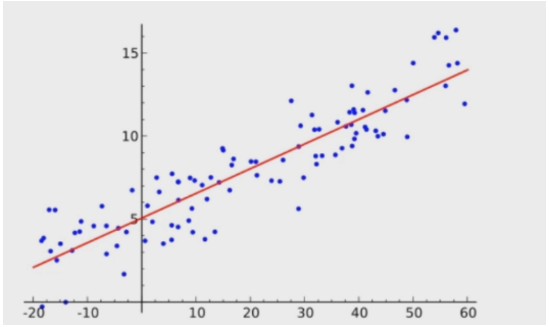

回歸算法與分類算法類似,區(qū)別是回歸是線性的分類是離散的

將所有輸入分布出來,擬合一條個函數(shù)表示這種分布(擬合的過程較訓練),根據(jù)這個函數(shù)的輸入求得輸出就是回歸

1.線性回歸:在回歸分析中,自變量與應變量基本滿足線性關(guān)系就可以用線性模型進行擬合

只有一個自變量叫一元線性回歸,自變量與應變量之間的關(guān)系可以用一條直線表示

多個自變量的叫多遠線性回歸,自變量與應變量之間的關(guān)系可以用一個平面或者超平面表示

線性回歸的前提條件

A.自變量與應變量之間有線性趨勢(皮爾遜相關(guān)系數(shù))

B.自變量之間沒有關(guān)聯(lián)

對于統(tǒng)計學習來講機器學習模型就是一個函數(shù)表達式,其訓練過程就是不斷更新這個函數(shù)式的參

數(shù),以便這個函數(shù)能夠多未知數(shù)據(jù)產(chǎn)生最好的預測結(jié)果

線性回歸的數(shù)學表達式

y=ax+b

y=Wt*X ,常用,其中W,X為列向量,Wt為W轉(zhuǎn)置,

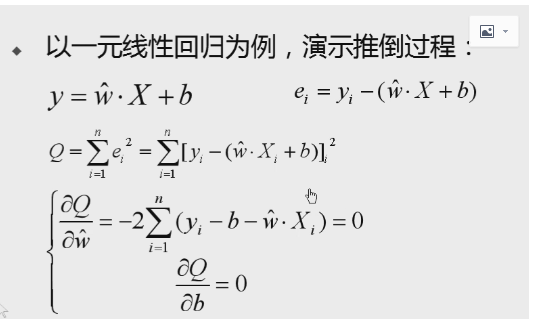

2.最小二乘法:通過最小化殘差平方和(數(shù)據(jù)點與它在回歸直線上相應位置的差異稱為殘差)來找到最佳的函數(shù)配比,導數(shù)的意義是函數(shù)曲線的斜率

掃一掃

掃一掃